자연어 처리 활용 분야와 트렌드

Sunghoon Kim

Sunghoon KimTable of contents

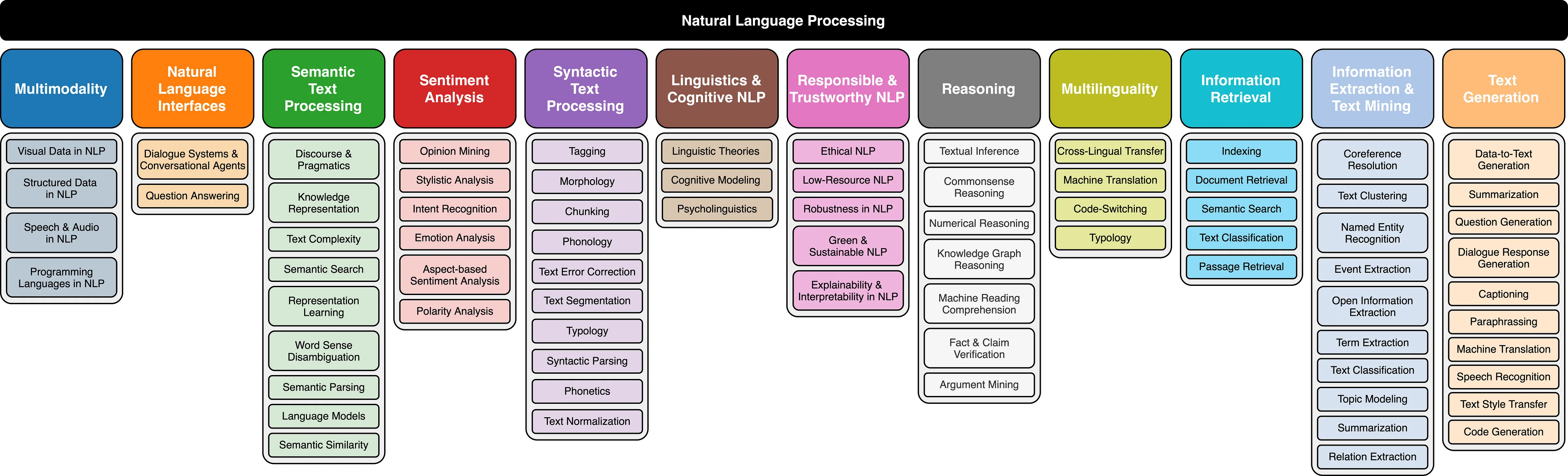

자연어 처리(NLP, Natural Language Processing)은 기본적으로 (1) 컴퓨터가 주어진 단어나 문장 그리고 보다 더 긴 문단이나 글을 이해하는 NLU(Natural Language Understading)과 (2) 이러한 자연어를 상황에 따라 적절히 생성할 수 있는 NLG(Natural Language Generation)이라 부르는 두 종류의 Task로 구성된다.

자연어 처리 분야별 학회 목록

NLP 분야는 CV 분야와 더불어 인공지능 및 딥러닝 기술이 가장 활발하게 적용되고 발전하는 분야라 할 수 있다.

주요 학회 : ACL, EMNLP, NAACL

학문 분야

Low-level parsing

Tokenization : 문장을 이루는 각 단어들을 정보 단위로 생각하고 토큰이라고 부르는데, 주어진 문장을 토큰 단위로 쪼개는 과정이다.

Stemming : 어미의 변화 속에서도 그 단어들이 모두 다 같은 의미를 나타내는 단어라는 것을 컴퓨터가 이해할 수 있어야 하고, 이러한 측면에 단어의 다양한 의미 변화를 없애고 그 의미만을 보존하는 어떤 그런 단어의 어근을 추출하는 것이다.

Word and phrase level

NER(Named Entity Recognation) : 단일 단어 혹은 여러 단어로 이루어진 어떤 고유 명사를 인식하는 것이다. (e.g. New York Times는 B-Loc I-Loc E-Loc 태그로 인식하도록 한다.)

POS(Part-Of-Speech) tagging : 문장 내에서의 단어들이 어떤 품사(주어, 동사 등)나 그 성분이 무엇 인지를 알아내는 것이다.

Sentence level

감성 분류(Sentiment Analysis) : 주어진 문장이 긍정 혹은 부정 어조인지 예측하는 것이다.

기계 번역(Machine Translation) : 번역을 수행하는 task이다.

Multi-sentence and paragraph level

논리적 내포 및 모순관계 예측(Entailment Prediction) : 두 문장 간의 논리적인 내포 혹은 모순 관계를 예측하는 것이다. (e.g. 어제 한 명도 결혼하지 않았다라는 문장이 주어지면 이 문장은 어제 존이 결혼했다라는 문장과는 양립할 수 없는 논리적으로 모순 관계를 가지게 된다.)

독해기반 질의응답(Question Answering) : 이 질문에 있는 키워드들이 포함된 문서들을 먼저 쭉 검색을 하고, 그 문서로부터 독해를 통해 주어진 질문에 대한 어떤 정답을 정확하게 알아내는 task이다.

챗봇(Dialog Systems) : 실시간 상호작용을 위한 task이다.

요약(Summarization) : 주어진 문서를 요약의 형태로 나타내는 task이다.

Text Mining 분야는 빅데이터 분석과 관련된 경우가 많다.

주요 학회 : KDD, The WebConf(前 WWW), WSDM, CIKM, ICWSM

학문 분야

Extract useful information and insights from text and document data

문서 군집화(Document Clustering) : ex) 토픽 모델링

Highly related to computational social science : 통계적으로 사회과학적 인사이트 산출

Information retrieval (정보 검색) 분야는 검색 기술을 주로 연구하는 분야이다. 하지만 현재의 검색 기술이 점차 고도화되면서 어느 정도 성숙한 상태에 이르렀다고 볼 수 있다. 이에 NLP나 Text Mining 분야에 비해 상대적으로 느린 분야라 볼 수 있다.

주요 학회 : SIGIR, WSDM, CIKM, Recsys

학문 분야

Highly related to computational social science

정보 검색 분야

추천 시스템 : 추천 시스템은 상업적으로도 굉장히 큰 임팩트를 가지는 분야로서 음악 영상에 대한 추천 시스템뿐만 아니라 개인화된 광고나 상품 추천에 이르기까지 다양한 분야에서 활발히 활용되고 있다.

자연어 처리 분야의 트렌드

기존 머신러닝과 딥러닝 기술로 자연어 처리 문제를 해결하기 위해서는 주어진 텍스트 데이터를 숫자로 변환하는(어떤 벡터 공간의 한 점으로 나타내는) 워드 임베딩(Word Embedding) 과정을 거치게 된다.

텍스트 데이터는 문장을 구성하는 순서 정보가 중요하기 때문에 이를 받아들일 수 있는 특화 모델에 대한 연구가 필요했고, 그 대표적인 예로는 RNN(Recurrent Neural Network)이 있다. 이후 단점을 보완한 LSTM, GRU 모델이 나왔다.

2017년에는 구글에서 발표한 Attention is all YOU need 라는 제목의 논문이 나오면서 셀프 어텐션(Self-Attention) 구조를 가진 트랜스포머(Transformer) 모델이 각광받기 시작했다. 최근 발표된 대부분의 모델들은 트랜스포머 모델을 기반으로 하는 것이 많으며, 트랜스포머 모델은 주로 사용되던 기계 번역 분야를 넘어 현재는 영상/신약개발/시계열 예측 등에서도 다양하게 사용되고 있다.

최근에는 자가지도 학습(self-supervised Learning)이 가능한 BERT, GPT 와 같은 모델의 유행하고 있다.

참고자료

Subscribe to my newsletter

Read articles from Sunghoon Kim directly inside your inbox. Subscribe to the newsletter, and don't miss out.

Written by