Yapay Zeka ve Büyük Dil Modelleri (LLM’ler) Yönetişimi ve Güvenliği | Softtech 2024 Teknoloji Raporu Yazım

Bulent Siyah

Bulent SiyahSofttech, Türkiye'nin lider teknoloji şirketlerinden biri olarak her yıl alanında uzman isimlerin görüşlerini içeren Teknoloji Raporu yayımlamaktadır. Bu yılki rapor, üretken yapay zeka teknolojileri odağında hazırlanmış olup; insanı yapay zekadan ayıran özellikler, iş dünyası, yapay yaşam, dijital yaşam ve fiziksel yaşam gibi konulara odaklanıyor. Ayrıca, Teknoloji Radarı bölümü, gelecekteki teknolojik gelişmelerle ilgili öngörüler sunarken, yapay zekanın iş gücü piyasasına olan etkilerini de detaylı şekilde inceliyor.

2024 te raporda “Yapay Zeka ve Büyük Dil Modelleri (LLM’ler) Yönetişimi ve Güvenliği” üzerine benimde naçizane bir yazım bulunmaktadır. Raporun tamamını https://softtech.com.tr/2024-softtech-teknoloji-raporu/ adresinden okuyabilirsiniz. Benim yazım 71. sayfada bulunmaktadır.

Yapay Zeka ve Büyük Dil Modelleri (LLM’ler) Yönetişimi ve Güvenliği

Yapay zeka ve büyük dil modelleri (LLM'ler), birçok sektörde ve hayatımızın her alanında devrim yaratma potansiyeliyle dünyamızı hızla dönüştürüyor. Ancak bu güç beraberinde büyük bir sorumluluk da getirmektedir. AI ve LLM'lerin sorumlu ve güvenli bir şekilde kullanılmasını sağlamak için etkili yönetişim ve güvenlik önlemlerinin alınması esastır. Yapay zeka ve büyük dil modeli yönetişimi ve güvenliğindeki temel zorlukları ve dikkat edilmesi gereken noktaları inceleyelim. Ayrıca bu alandaki en son gelişmeleri ve uygulamaları tartışalım.

Zorluklar ve Dikkat Edilmesi Gerekenler

Yapay zeka ve büyük dil modeli yönetişimi ve güvenliğinde bir dizi benzersiz zorluk ve husus vardır. Yapay zeka ve büyük dil modelleri, özellikle de karmaşık sistemlerin nasıl çalıştığını anlamak göz korkutucu bir görev olabilir. Bu şeffaflığın eksikliği, geliştiricilerin ve kullanıcıların eylemlerinden sorumlu tutulmasını zorlaştırabilir. Bu teknolojilerin geliştirilmesi ve kullanılması sırasında şeffaflık ve hesap verebilirlik için açık mekanizmalar oluşturmak çok önemlidir.

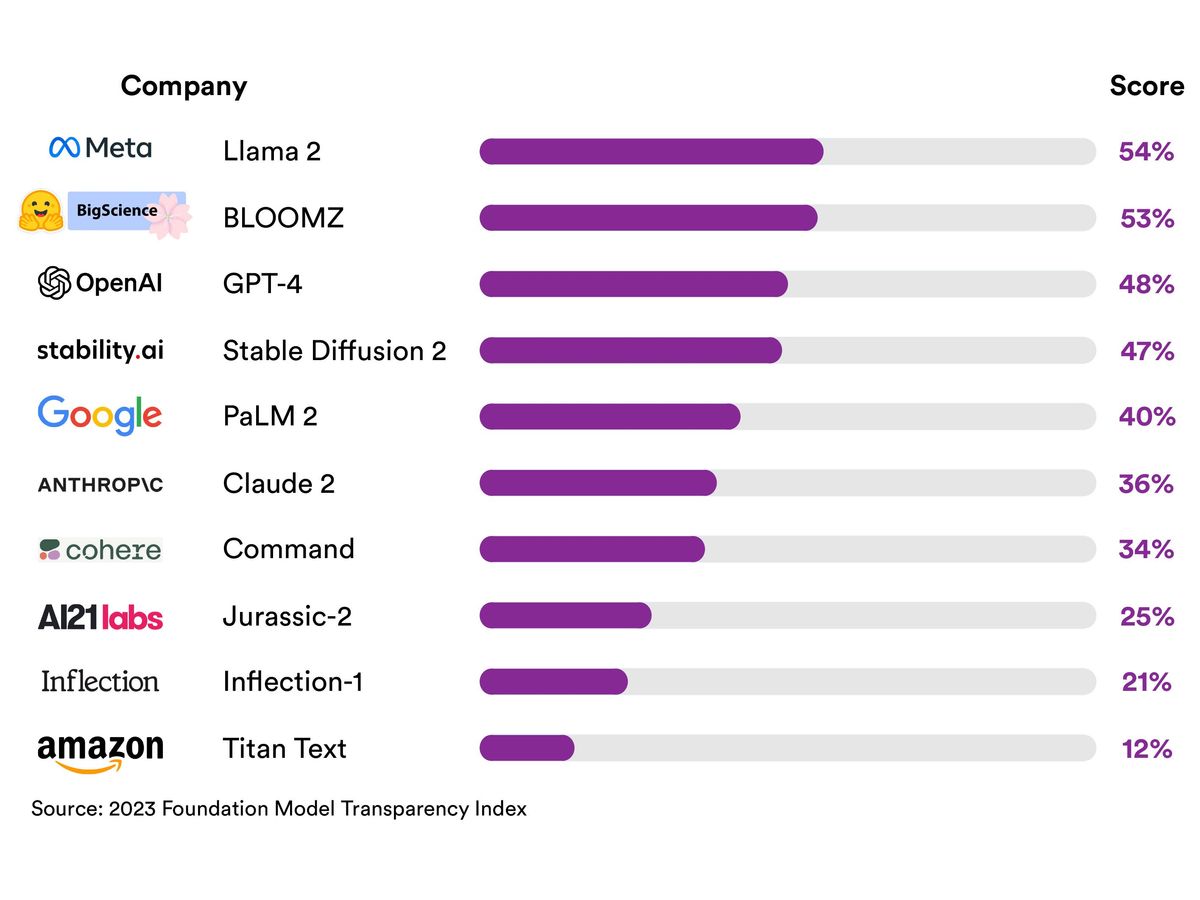

[1] 2023 Kaynak Modellerin Şeffaflık Endeksi

AI ve LLM'ler, gerçek dünyanın önyargılarını ve ayrımcılığını yansıtabilecek veriler üzerinde eğitilir. Bu, adil olmayan ve ayrımcı sonuçlara yol açarak mevcut toplumsal eşitsizlikleri güçlendirebilir. Önyargıyı ele almak ve yapay zeka sistemlerinde adaleti sağlamak önemli bir sorumluluktur.

AI ve LLM'ler, bireylerin mahremiyetine ve genel güvenliğine tehdit oluşturan yeni ve güçlü saldırı ve gözetleme biçimleri oluşturmak için kullanılabilir. Potansiyel tehditlere karşı korunmak için şifreleme, erişim kontrolü ve denetim dahil olmak üzere güçlü güvenlik önlemleri gerekmektedir.

AI ve LLM'ler, demokrasi ve sosyal uyum üzerinde yıkıcı etkileri olabilecek gerçekçi ancak yanlış bilgiler üretmek için kullanılabilir. Yanlış bilgilerin ve dezenformasyonun yayılmasının önlenmesi, yapay zeka yönetişiminde kritik bir endişe kaynağıdır.

En Son Gelişmeler ve En İyi Uygulamalar

Bir dizi kuruluş ve girişim, yapay zeka ve büyük dil modeli yönetişimi ve güvenliğindeki bu zorlukları çözmek için aktif olarak çalışmaktadır. Bu alandaki en son gelişmelerden ve en iyi uygulamalardan bazıları şunlardır:

Birleşmiş Milletler (BM), yapay zeka ile ilişkili risklerin değerlendirilmesi ihtiyacını kabul etmiştir. Bu riskleri ele alan ve yapay zeka yönetimini geliştiren çerçeveler geliştirmek için Google ve Microsoft gibi büyük teknoloji şirketlerinin işbirliği aradı. Google, yapay zeka güvenliği araştırmalarına yatırım yapmaktadır ve hatta yapay zeka güvenliğine odaklanan yeni bir şirket olan Anthropic’i bile kurmuştur. Bu, yapay zeka güvenliği ve güvenliğinin öneminin giderek daha fazla kabul edildiğini gösteriyor.

Yapay zeka araştırmalarında lider bir kuruluş olan OpenAI, özellikle yapay zeka ile ilişkili "felaket risklerini" değerlendirmeye adanmış yeni bir ekip kurmuştur. Bu, yapay zeka geliştirmede proaktif risk yönetimi ihtiyacının altını çizmektedir.

Startup'lar, kuruluşların yapay zeka sistemlerini izlemelerine, yönetmelerine ve güvence altına almalarına yardımcı olacak yenilikçi araç ve teknolojilerle ortaya çıkmaktadır. Bu girişimler, yapay zeka güvenlik uygulamalarının geliştirilmesinde çok önemli bir rol oynamaktadır.

Yapay zeka ve büyük dil modeli yönetişimi ve güvenliğine yönelik en iyi uygulamalar, kuruluşların AI ve LLM'leri kullanım şekilleri konusunda şeffaf olmalarını, geliştiricileri ve kullanıcıları eylemlerinden sorumlu tutacak açık politikalar ve prosedürler oluşturmalarını, AI ve LLM sistemlerinde önyargının azaltılmasını ve önyargıyı tespit etmek ve ele almak için çeşitli eğitim verilerinin kullanılmasını içermeli, aynı zamanda güçlü güvenlik ve gizlilik önlemleri olan şifreleme, erişim kontrolü ve sağlam denetim prosedürlerini uygulayarak AI ve LLM sistemlerini korumalarını gerektirir.

Kuruluşların, yapay zeka ve LLM’lerin yanlış bilgi ve dezinformasyon üretme ve yayma amacıyla kötüye kullanılmasını önleyecek politika ve prosedürleri olmalıdır. Çıktıların insanlar tarafından incelenmesi ve doğrulama araçları bu bağlamda değerli olabilir.

Çözüm

Yapay zeka ve LLM'ler, hayatımızın birçok alanında devrim yaratabilme potansiyeline sahiptir. Ancak bunların sorumlu ve güvenli bir şekilde kullanılabilmesini sağlamak için etkili yönetim ve güvenlik önlemleri alınmalıdır. Kuruluşlar şeffaflığa, hesap verebilirliğe, adalete, güvenliğe ve gizliliğe öncelik vermeli ve bu teknolojilerin yanlış bilgi üretmek amacıyla kötüye kullanılmasını önlemek için önlemler almalıdır. Yukarıda tartışılan zorluklara ve konulara ek olarak, AI ve LLM'leri kullanmanın etik sonuçlarını dikkate almak ve bunları insan değerleriyle uyumlu hale getirmek son derece önemlidir. Uzun vadeli toplumsal etkileri düşünmek ve bu teknolojilerin sorumlu ve faydalı kullanımını teşvik eden politikalar ve düzenlemeler geliştirmek de gereklidir. Yapay zeka ve LLM'ler gelişmeye ve yaygın olarak benimsenmeye devam ettikçe, sağlam ve etkili bir yönetişim ve güvenlik çerçevesine sahip olmanın hayati önem taşıdığını unutmamak önemlidir. Bu çerçeve, bu teknolojilerin daha büyük yarar sağlamasını sağlamanın yanı sıra ilgili riskleri de azaltacaktır. Sorumlu yapay zeka geliştirme ve kullanımı, daha adil ve güvenli bir geleceğin şekillenmesine büyük katkıda bulunacaktır.

Sonuç

Yapay zeka ve büyük dil modelleri (LLM’ler), yaşantımızı kökten değiştirmeye yönelik büyük bir potansiyele sahiptir. Ancak, bu güçle birlikte büyük sorumluluklar gelir. Yapay zeka ve LLM’lerin sorumlu ve güvenli bir şekilde kullanılabilmesi için etkili bir yönetişim ve güvenlik çerçevesine sahip olmak son derece önemlidir. Kuruluşlar, kullanılan yapay zeka ve LLM’lerin nasıl kullanıldığına dair şeffaf olmalı, geliştiricileri ve kullanıcıları eylemleri konusunda hesap verebilir kılacak net politika ve prosedürler uygulamalıdır. Ayrıca, önyargıyı azaltma, güvenlik ve gizliliği koruma ve yanlış bilgiyi yaymak konusunda önlem almalıdır. Bu, yapay zeka ve LLM’lerin güvenli ve sorumlu bir şekilde kullanılmasını sağlayacak ve bu teknolojilerle ilişkilendirilen riskleri azaltacaktır. Yapay zeka ve LLM’lerin gelişmeye devam etmesi ve daha geniş bir şekilde benimsenmesiyle, sağlam ve etkili bir yönetişim ve güvenlik çerçevesine sahip olmanın vazgeçilmez olduğu bir gerçektir. Bu çerçeve, bu teknolojilerin sadece iyilik için kullanılmasını değil, aynı zamanda bunlarla ilişkilendirilen riskleri azaltmayı da sağlayacaktır. Sorumlu yapay zeka geliştirme ve kullanımı, daha adil ve güvenli bir geleceğin şekillenmesinde hayati bir rol oynamaktadır.

Kaynaklar

[1] Top AI Shops Fail Transparency Test:

[https://spectrum.ieee.org/ai-ethics]

[2] Over half of employees have no idea how their companies use ai: [https://www.cnbc.com/2023/10/24/over-half-of-employees-have-no-idea-how-their-companies-use-ai.html]

[3] UN Asks Google, Microsoft to Help It Figure Out How Risky AI Is: [https://gizmodo.com/un-wants-figure-out-just-how-dangerous-ai-is-1850966058]

[4] Google to invest another $2B in AI firm Anthropic: Report: [https://cointelegraph.com/news/google-to-invest-another-two-billion-in-ai-firm-anthropic]

[5] OpenAI forms new team to assess ‘catastrophic risks’ of AI: [https://finance.yahoo.com/news/openai-forms-team-whose-mission-171353116.html?guccounter=1]

[6] Cranium raises $25M to fund enterprise AI monitoring, security, and compliance platform:

[7] Generative AI training data sets are now trackable — and often legally complicated:

[8] Google will require Android apps to better moderate AI-generated content:

[https://www.theverge.com/2023/10/25/23931732/android-generative-ai-rules-app-developer-policy-google]

[9] Tech Experts Warn Humanity Must Act Now to Avoid ‘Societal-Scale’ Damage by AI:

[https://www.commondreams.org/news/risks-of-artificial-intelligence]

[10] AI firms must be held responsible for harm they cause, ‘godfathers’ of technology say:

Subscribe to my newsletter

Read articles from Bulent Siyah directly inside your inbox. Subscribe to the newsletter, and don't miss out.

Written by

Bulent Siyah

Bulent Siyah

You can access my work in all areas on my website www.bulentsiyah.com