¡Convierte los Modelos de IA en tus Compañeros de Piso Perfectos! (ServBay+Ollama+ChatBox)

Dheeraj Malhotra

Dheeraj MalhotraAl principio de todo:

Recientemente, DeepSeek se ha vuelto tan popular que todos quieren probarlo. La llegada de DeepSeek puede decirse que ha provocado un auge de la IA a nivel nacional.

Inicialmente, pensé que desplegar DeepSeek localmente sería muy desafiante, pero después de probarlo, resultó ser bastante simple. El proceso es tan fácil como instalar un nuevo software en tu ordenador, y solo toma unos diez minutos completar el despliegue local.

Hoy, hablemos sobre cómo desplegar el modelo DeepSeek-R1-1.5B localmente en tu propio ordenador.

Resumen de los Pasos de Instalación:

Instala ServBay: ¿Por qué instalarlo? Porque te permite instalar Ollama con un solo clic e instalar DeepSeek con un solo clic.

Instala una GUI que soporte Ollama: ¿La interfaz de línea de comandos no es amigable? No te preocupes, tenemos la GUI perfecta preparada para ti.

¡Comienza conversaciones fluidas con DeepSeek!

Ⅰ. ¿Por qué Desplegar DeepSeek Localmente?

Algunos de vosotros podéis compartir la misma experiencia que yo: encontrar frecuentemente el mensaje "Servidor ocupado, por favor inténtelo de nuevo más tarde" al usar DeepSeek. Sin embargo, con el despliegue local, este problema simplemente no existe.

Recomiendo a todos desplegar el modelo DeepSeek-R1-1.5B. ¿Por qué esta versión? Aquí está el porqué:

Compacto y Eficiente: DeepSeek-R1-1.5B es un modelo ligero con solo 1.5 mil millones de parámetros. Suena "pequeño", ¿verdad? Pero no lo subestimes: ¡este es un modelo "pequeño pero poderoso"! Solo requiere 3GB de VRAM para funcionar, lo que significa que incluso ordenadores con configuraciones modestas pueden manejarlo con facilidad. Además, funciona excepcionalmente bien en razonamiento matemático, incluso superando a GPT-4o y Claude 3.5 en algunas pruebas comparativas. Por supuesto, si tu ordenador tiene una configuración más alta, puedes optar por otras versiones.

Mayor Flexibilidad: Los modelos grandes desplegados localmente ofrecen más flexibilidad, ya que generalmente no están limitados por plataformas externas. Los usuarios obtienen un control completo sobre el comportamiento y el contenido del modelo.

Sin Censura de Contenido: Los modelos grandes a los que se accede a través de llamadas API pueden enfrentar restricciones de las políticas de contenido del proveedor de servicios (por ejemplo, ChatGPT de OpenAI limita las respuestas sobre temas delicados). Sin embargo, los modelos desplegados localmente se pueden ajustar según las necesidades del usuario, lo que permite discusiones sobre una gama más amplia de temas.

Protección de la Privacidad: Todos los datos se procesan localmente sin necesidad de subirlos a la nube, lo que lo hace adecuado para escenarios con altos requisitos de privacidad de datos.

Control Total: Los usuarios tienen control total sobre el entorno de ejecución del modelo, las entradas y salidas de datos, así como las actualizaciones y optimizaciones del modelo.

En resumen, el despliegue local elimina los errores de respuesta y mejora significativamente la satisfacción del usuario. Los usuarios con otros requisitos pueden consultar el contenido a continuación para obtener opciones alternativas.

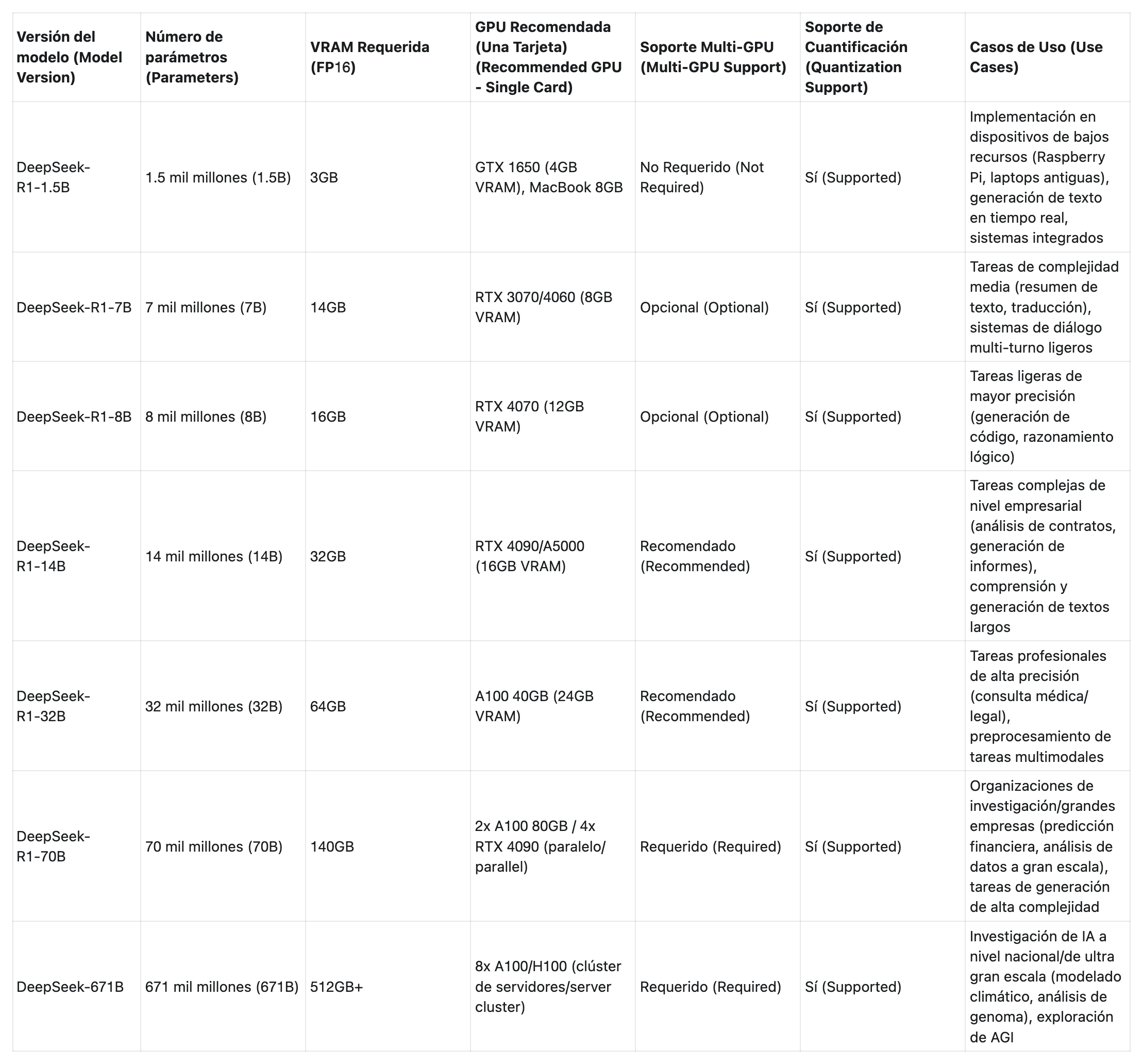

II. Requisitos de Hardware para Diferentes Versiones de DeepSeek

A continuación, se muestran los requisitos de hardware para diferentes versiones del modelo DeepSeek. Puedes elegir la versión que mejor se adapte a la configuración de tu ordenador.

Ⅲ. Pasos de Despliegue

1. Descarga ServBay

Requiere macOS 12.0 Monterey o posterior. Actualmente, no admiten una versión de Windows, pero según la declaración oficial, estará disponible pronto. Descarga la última versión de ServBay

El archivo de instalación es de solo 20MB.

Pasos de Instalación

Haz doble clic en el archivo .dmg descargado.

En la ventana que se abre, arrastra el icono de ServBay.app a la carpeta Aplicaciones.

- Cuando uses ServBay por primera vez, se requiere inicialización.

Selección con un Clic de Ollama

Una vez completada la instalación, abre ServBay para comenzar a usarlo.

Introduce la contraseña. Una vez completada la instalación, puedes encontrar ServBay en el directorio Aplicaciones.

Accede a la interfaz principal. Originalmente, Ollama requería un proceso complejo para instalar e iniciar servicios, pero con ServBay, puedes comenzar con un solo clic, instalar los modelos de IA que necesites y ya no preocuparte por configurar variables de entorno. Incluso los usuarios comunes sin conocimientos de desarrollo pueden usarlo con solo un clic. Inicio y parada con un solo clic, descargas rápidas de modelos multiproceso y, siempre que tu sistema macOS sea suficiente, puedes ejecutar múltiples modelos grandes de IA simultáneamente.

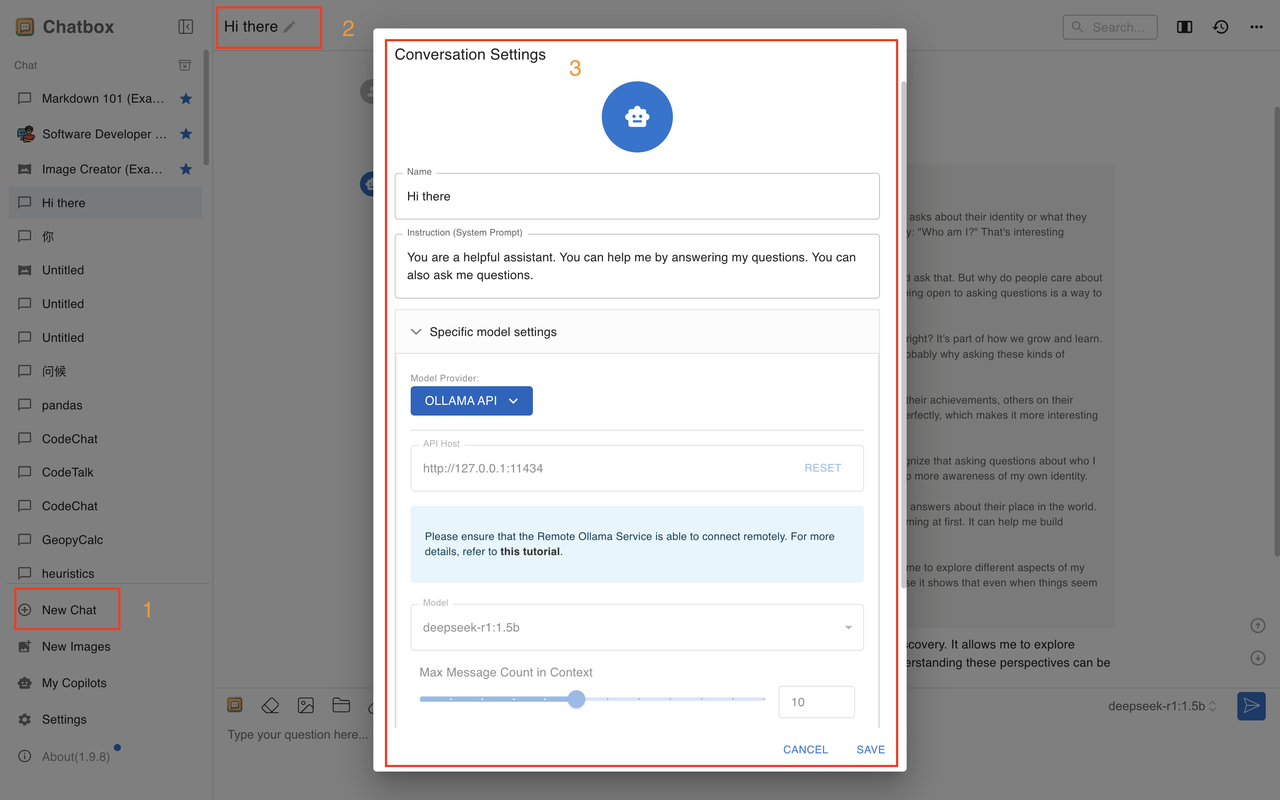

Recuerda la ruta local y el número de puerto de Ollama

Descarga con un Clic de DeepSeek

En mi ordenador, la velocidad de descarga de DeepSeek8B incluso superó los 60 MB por segundo, superando por completo a otras herramientas similares.

Con ServBay y Ollama, pude desplegar DeepSeek localmente. ¡Mira, está funcionando sin problemas!

De esta manera, hemos logrado el despliegue local de modelos grandes usando ServBay + Ollama. Sin embargo, actualmente se limita a la línea de comandos, ¡y aún no hay GUI!

2. Recomendación de GUI - Chatbox (Probado Personalmente, la Mejor Opción)

Chatbox es fácil de usar (Gratuito, potente, admite la carga de archivos, Calificación de recomendación: 🌟🌟🌟🌟🌟).

Después de la descarga, accede a la interfaz principal:

Haz clic en la configuración y sigue los pasos para realizar modificaciones.

Guarda los cambios y podrás iniciar conversaciones. Verás que las modificaciones se han aplicado correctamente.

Con esto, hemos completado el despliegue completo del modelo DeepSeek-R1-1.5B basado en ServBay.

Resumen:

Amigos, ¿no es increíblemente fácil desplegar localmente el modelo DeepSeek-R1-1.5B usando ServBay? Siguiendo los pasos anteriores, solo toma 10 minutos convertir tu ordenador en un "asistente inteligente".

Además, este modelo no solo se ejecuta de manera eficiente, sino que también puede tener un gran impacto en varios escenarios. ¡Adelante, pruébalo!

Subscribe to my newsletter

Read articles from Dheeraj Malhotra directly inside your inbox. Subscribe to the newsletter, and don't miss out.

Written by