Machen Sie KI-Modelle zu Ihren perfekten Mitbewohnern! (ServBay+Ollama+ChatBox)

Dheeraj Malhotra

Dheeraj MalhotraGanz am Anfang:

In letzter Zeit ist DeepSeek so populär geworden, dass jeder es ausprobieren möchte. Man kann sagen, dass die Ankunft von DeepSeek einen landesweiten KI-Hype ausgelöst hat.

Anfangs dachte ich, dass die lokale Bereitstellung von DeepSeek sehr herausfordernd sein würde, aber nach dem Testen stellte sich heraus, dass es ziemlich einfach ist. Der Prozess ist so einfach wie die Installation neuer Software auf Ihrem Computer und dauert nur etwa zehn Minuten, um die lokale Bereitstellung abzuschließen.

Lassen Sie uns heute darüber sprechen, wie Sie das DeepSeek-R1-1.5B-Modell lokal auf Ihrem eigenen Computer bereitstellen können.

Übersicht über die Installationsschritte:

Installieren Sie ServBay: Warum sollten Sie es installieren? Weil es Ihnen ermöglicht, Ollama mit einem Klick zu installieren und DeepSeek mit einem Klick zu installieren.

Installieren Sie eine GUI, die Ollama unterstützt: Ist die Befehlszeilenschnittstelle nicht benutzerfreundlich? Keine Sorge, wir haben die perfekte GUI für Sie vorbereitet.

Beginnen Sie nahtlose Gespräche mit DeepSeek!

Ⅰ. Warum DeepSeek lokal bereitstellen?

Einige von Ihnen haben vielleicht die gleiche Erfahrung wie ich gemacht – häufig auf die Meldung "Server ausgelastet, bitte versuchen Sie es später erneut" zu stoßen, wenn Sie DeepSeek verwenden. Bei lokaler Bereitstellung existiert dieses Problem jedoch einfach nicht.

Ich empfehle jedem, das DeepSeek-R1-1.5B-Modell bereitzustellen. Warum diese Version? Hier ist der Grund:

Kompakt und effizient: DeepSeek-R1-1.5B ist ein leichtgewichtiges Modell mit nur 1,5 Milliarden Parametern. Klingt "winzig", oder? Aber unterschätzen Sie es nicht – das ist ein "kleines, aber feines" Modell! Es benötigt nur 3 GB VRAM zum Ausführen, was bedeutet, dass selbst Computer mit bescheidenen Konfigurationen es problemlos bewältigen können. Darüber hinaus schneidet es beim mathematischen Denken außergewöhnlich gut ab und übertrifft in einigen Benchmarks sogar GPT-4o und Claude 3.5. Wenn Ihr Computer eine höhere Konfiguration hat, können Sie natürlich auch andere Versionen wählen.

Höhere Flexibilität: Lokal bereitgestellte große Modelle bieten mehr Flexibilität, da sie in der Regel nicht durch externe Plattformen eingeschränkt sind. Benutzer erhalten die volle Kontrolle über das Verhalten und den Inhalt des Modells.

Keine Inhaltszensur: Große Modelle, auf die über API-Aufrufe zugegriffen wird, können Einschränkungen durch die Inhaltsrichtlinien des Dienstanbieters unterliegen (z. B. schränkt ChatGPT von OpenAI Antworten zu sensiblen Themen ein). Lokal bereitgestellte Modelle können jedoch an die Bedürfnisse des Benutzers angepasst werden, was Diskussionen über ein breiteres Themenspektrum ermöglicht.

Datenschutz: Alle Daten werden lokal verarbeitet, ohne dass sie in die Cloud hochgeladen werden müssen, was es für Szenarien mit hohen Datenschutzanforderungen geeignet macht.

Volle Kontrolle: Benutzer haben die volle Kontrolle über die Laufzeitumgebung des Modells, die Datenein- und -ausgaben sowie über Aktualisierungen und Optimierungen des Modells.

Zusammenfassend lässt sich sagen, dass die lokale Bereitstellung Antwortausfälle beseitigt und die Benutzerzufriedenheit erheblich verbessert. Benutzer mit anderen Anforderungen können den folgenden Inhalt für alternative Optionen konsultieren.

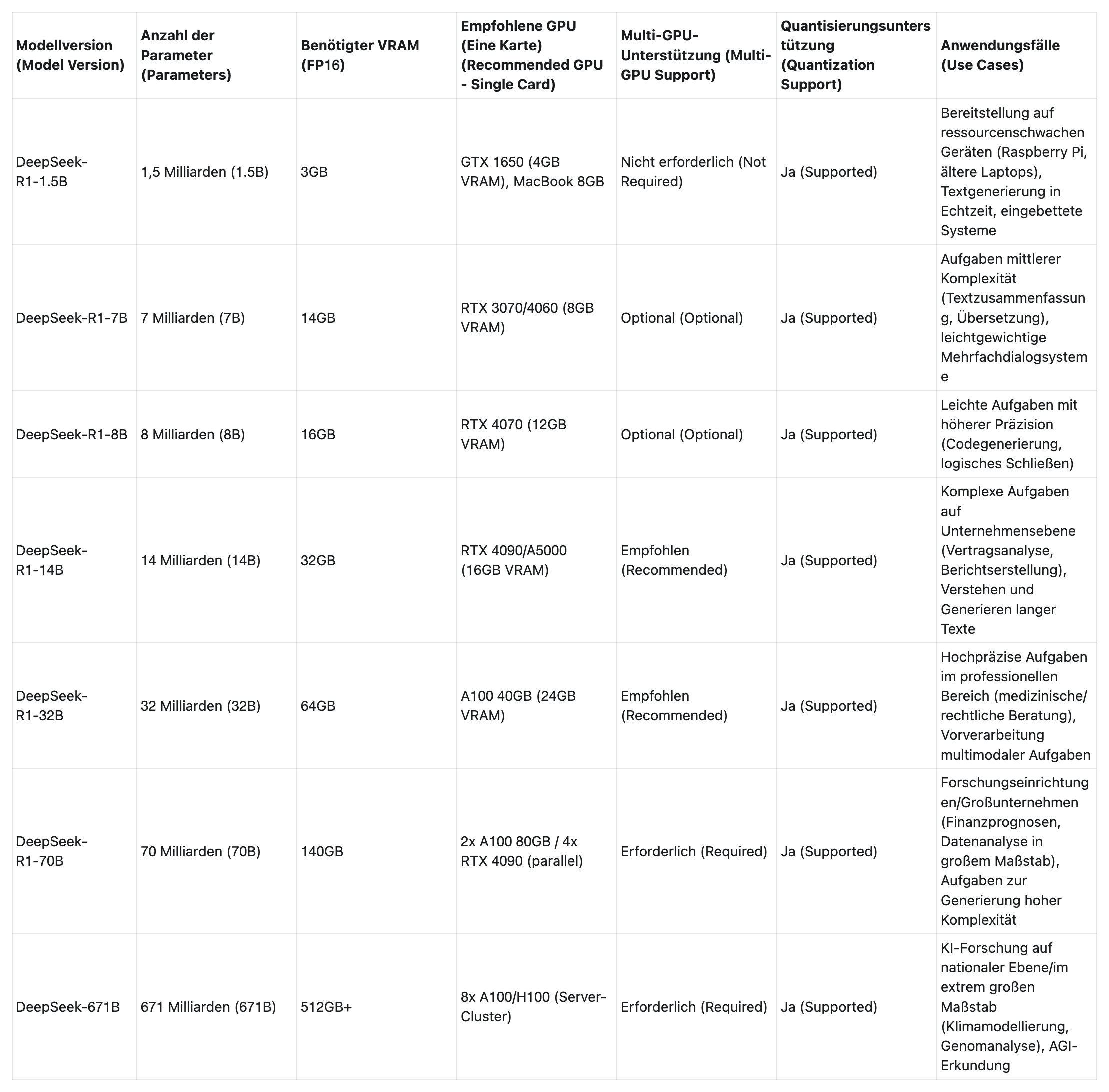

II. Hardware-Anforderungen für verschiedene Versionen von DeepSeek

Nachfolgend sind die Hardware-Anforderungen für verschiedene Versionen des DeepSeek-Modells aufgeführt. Sie können die Version auswählen, die am besten zur Konfiguration Ihres Computers passt.

Ⅲ. Bereitstellungsschritte

1. ServBay herunterladen

Erfordert macOS 12.0 Monterey oder höher. Derzeit wird keine Windows-Version unterstützt, aber laut offizieller Aussage wird diese bald verfügbar sein. Laden Sie die neueste Version von ServBay herunter

Die Installationsdatei ist nur 20 MB groß.

Installationsschritte

Doppelklicken Sie auf die heruntergeladene .dmg-Datei.

Ziehen Sie im geöffneten Fenster das ServBay.app-Symbol in den Ordner "Programme".

- Bei der ersten Verwendung von ServBay ist eine Initialisierung erforderlich.

Ein-Klick-Auswahl von Ollama

Sobald die Installation abgeschlossen ist, öffnen Sie ServBay, um es zu verwenden.

Geben Sie das Passwort ein. Sobald die Installation abgeschlossen ist, finden Sie ServBay im Verzeichnis "Programme".

Greifen Sie auf die Hauptoberfläche zu. Ursprünglich erforderte Ollama einen komplexen Prozess zum Installieren und Starten von Diensten, aber mit ServBay können Sie mit einem einzigen Klick starten, die benötigten KI-Modelle installieren und müssen sich keine Gedanken mehr über die Konfiguration von Umgebungsvariablen machen. Selbst normale Benutzer ohne Entwicklungskenntnisse können es mit nur einem Klick verwenden. Ein-Klick-Start und -Stopp, schnelle Modell-Downloads mit mehreren Threads, und solange Ihr macOS-System ausreichend ist, können Sie mehrere große KI-Modelle gleichzeitig ausführen.

Merken Sie sich den lokalen Pfad und die Portnummer von Ollama

DeepSeek Ein-Klick-Download für DeepSeek

Auf meinem Computer überstieg die Download-Geschwindigkeit für DeepSeek8B sogar 60 MB pro Sekunde und übertraf damit andere ähnliche Tools vollständig.

Mit ServBay und Ollama konnte ich DeepSeek lokal bereitstellen. Schauen Sie, es läuft reibungslos!

Auf diese Weise haben wir die lokale Bereitstellung großer Modelle mit ServBay + Ollama erreicht. Derzeit ist es jedoch auf die Befehlszeile beschränkt, und es gibt noch keine GUI!

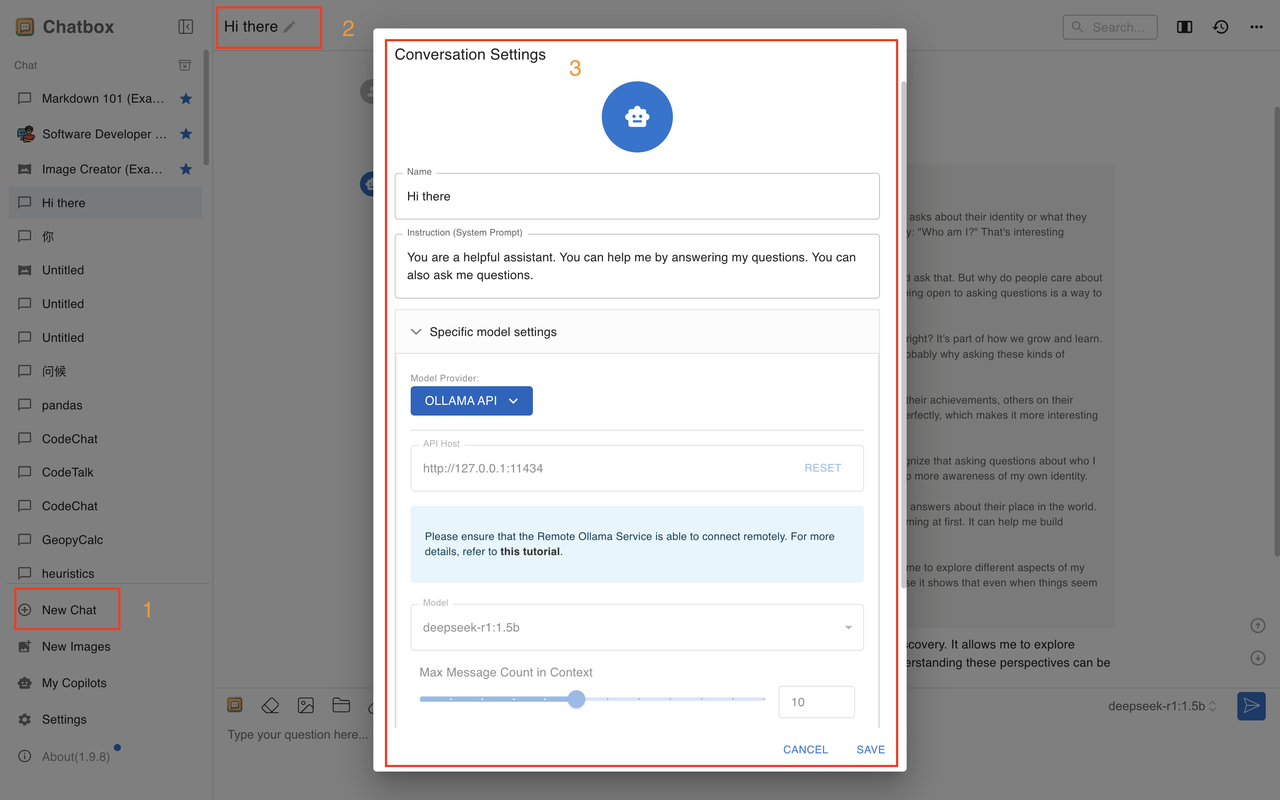

2. GUI-Empfehlung - Chatbox (persönlich getestet, beste Option)

Chatbox ist einfach zu bedienen (kostenlos, leistungsstark, unterstützt Datei-Uploads, Empfehlungsbewertung: 🌟🌟🌟🌟🌟).

Nach dem Herunterladen greifen Sie auf die Hauptoberfläche zu:

Klicken Sie auf Einstellungen und folgen Sie den Schritten, um Änderungen vorzunehmen.

Speichern Sie die Änderungen, und Sie können mit den Gesprächen beginnen. Sie werden sehen, dass die Änderungen erfolgreich übernommen wurden.

Damit haben wir die vollständige Bereitstellung des DeepSeek-R1-1.5B-Modells auf Basis von ServBay abgeschlossen.

Zusammenfassung:

Freunde, ist es nicht unglaublich einfach, das DeepSeek-R1-1.5B-Modell lokal mit ServBay bereitzustellen? Wenn Sie die oben genannten Schritte befolgen, dauert es nur 10 Minuten, um Ihren Computer in einen "intelligenten Assistenten" zu verwandeln.

Darüber hinaus läuft dieses Modell nicht nur effizient, sondern kann auch in verschiedenen Szenarien eine große Wirkung entfalten. Probieren Sie es aus!

Subscribe to my newsletter

Read articles from Dheeraj Malhotra directly inside your inbox. Subscribe to the newsletter, and don't miss out.

Written by